論文紹介:Information-based Active SLAM via Topological Feature Graphs

どんなもの

Topological Feature Graph(TFG)を使ったActive SLAMの提案。占有格子地図(Occupancy Grid Map)に比べ、地図のスケールの精度や長時間実行時のドリフトが少ない。

先行研究と比べてどこがすごい?

特徴量ベースなトポロジカルマップでActive SLAMを可能にしたこと。

Active SLAM

未知領域に対し、ロボット自身がパスプランニングして行うSLAM

技術の手法やキモはどこ?

どうやって有効と検証?

シミュレーション上で、変数の数やCPUのアイドル時間、位置・姿勢の誤差を比較した。姿勢の誤差を除き、全て占有格子地図を使ったActive SLAM(nearest-frontier exploration algorithm)よりもよい性能を示した。

議論はある?

比較対象が、占有格子地図(メトリックマップタイプの地図)のSLAMであるため、TFGと同じトポロジカルマップのActive SLAMと比べる必要がある。

次に読むべき論文?

今は思いつかず

Probabilistic Robotics - Chap.9 Occupancy Grid Mapping

9.1 Introduction

今まではロボットが動作を開始する前に、環境地図が既知であることを仮定していた。ただこれは現実世界では稀なケースである。そこでロボットが自律的に環境地図を知る必要がある。ただし、環境地図の獲得には、下記2つの理由から困難な課題の1つである。

- 地図の候補空間は巨大である

- 地図を得ることは"鶏と卵"の問題がある

困難度合いを決める要因には、下記4つがある。

- 地図のサイズ(地図を作る上で対象となる空間の大きさ)

- 認識・動作におけるノイズの程度

- 認識の曖昧さ(特徴量が少ない、似たような光景が広がっているなど)

- 周回路(ループクロージャの問題)

本章では、ロボットの姿勢は既知と仮定(問題)。Grid Mappingは、ロボットの姿勢が既知という仮定の元、ノイズを含む不確かなセンサデータから環境地図を生成する技術である。地図中の各Gridは、

か

のどちらかの値を取る。どちらの値を取るかは、近似的に実装する事後確率で表現する。

Occupancy Grid Mapは、SLAMやパスプランニングに使うことは少ない。

9.2 The Occupancy Grid Mapping Algorithm

環境地図に関する事後確率は

で表される。ここでは、計測開始後から現在までのロボットの経路(各時刻でのロボットの姿勢)を、

は計測開始後から現在までのセンサデータを、それぞれ表す。

なおOccupancy Grid Mapは一般的に2次元の地図を表すが、何層にも重ねることで3次元の地図を形成することもできる。ただし計算コストが膨大なため、通常Occupancy Grid Mapで3次元地図は構成しない。

環境地図は、沢山のセルで構成されることから、

とできる。このとき、

とする。

式(9.1)の問題は、次元数である。もしも地図が10,000個のセルで構成される場合、地図の次元はとなる。そのため、地図がセルの集合体だと考えると、計算量が膨大となる。

そこで標準的なOccupancy Grid Mapは、各セルに注目して事後確率を計算する。つまりを計算し、

のように統合することで、環境地図の事後確率を求める。

Occupancy Grid Mappingでは、各グリッドの状態を表すのに下記式(9.5)で表される対数オッズを使う。

対数オッズを使うメリットは、事後確率が計算結果が不安定になる0、1の近傍を取らなくなることである。

なお式中のは、対数オッズで表現されるOccupancy Grid Mapの事前分布で、

とする。ここで、であり、

である。

なお、Occupancy Grid Mapを作成する時は、ロボット自身が専有する領域(ロボットの身体)を考慮することは大切である。特に通行人が多いとき等には有用である。

9.3 Learning Inverse Measurement Models

9.3.1 Inverting the Measurement Model

Occupancy Grid Mapは、各セルの逆観測モデルが必要である。

Table9.2ではとりあえずの逆観測モデルを定義した。

ここでいう逆観測モデルは、複数のマップを用意し、それぞれのマップのを満たすマップを使って逆観測モデルを近似する。つまり、

となる。上記の式は計算不可能のため、ロジスティクス回帰やニューラルネットワーク等の教師付き学習アルゴリズムを使って近似的に求める。

Probabilistic Robotics - Chap.6 Robot Perception

1.Introduction

6章に記載されているのはEnvironment Measurement Model(環境計測モデル)

確率ロボティクスではセンサデータの計測に伴うノイズもモデル化する

確率ロボティクスでは、センサモデルの不正確さに対し、統計的手法を用いて対応する

この式は、がそれぞれ独立していることを仮定しているが、理想状態でしかそれはありえない。

6.2 Maps

地図はオブジェクトのリストを表す

地図には2種類ある

- 特徴ベース:オブジェクトの位置は地図中に含まれている。形状情報のみ特徴として持つ。そのため、ロボット用のマップとしてはこちらの形式がよく使われる。

- 位置ベース:

の要素は環境中に存在するオブジェクトの位置を表す。各オブジェクトの位置をデータとして保つ必要があるので、データサイズが大きい。空きスペースに関しての情報も保つ必要がある、つまり全セルの情報を保つ必要がある。

6.3 Beam Models of Range Finders

Range Finderは最もよく使われるセンサ

6.3.1 The Basic Measurement Algorithm

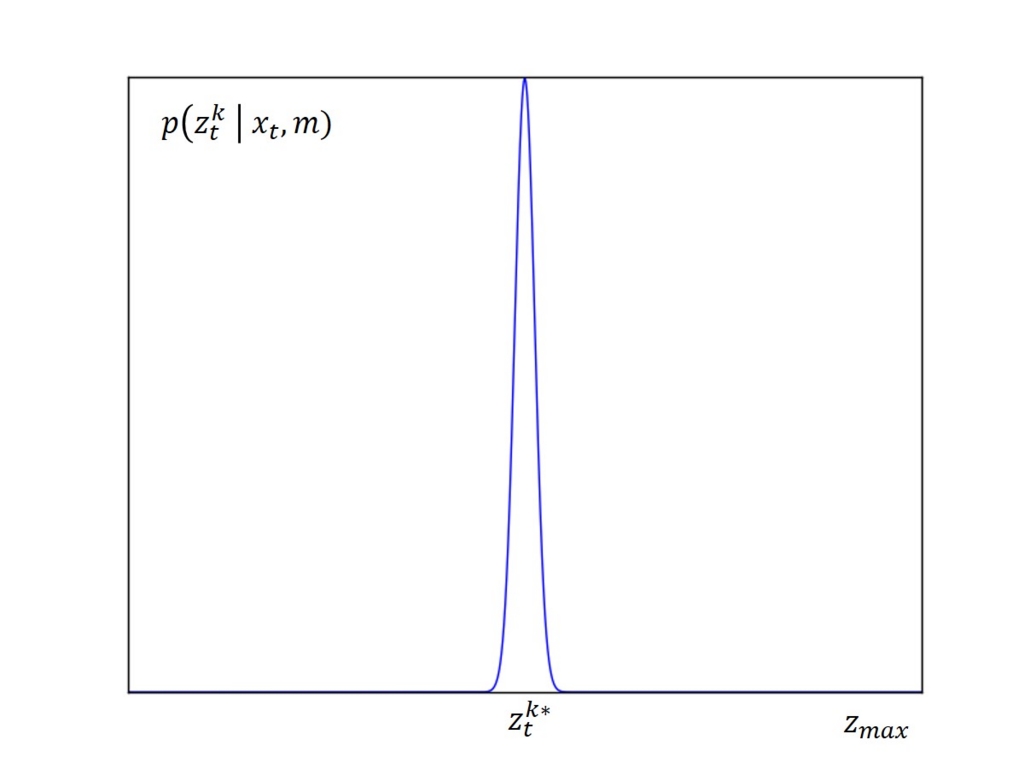

ここで紹介するモデルは4つのエラーを考慮する

- 分解能によって生じる誤差

正しい距離は計測できているものの、分解能の制約により誤差が乗る場合がある。

正しい距離をとする

本計測誤差は、平均、分散

で表される狭いガウス分布でモデル化できる。

は本ノイズモデル固有のパラメータ

- 予想外の物体

環境地図に元々含まれていない物体は、元々の地図に記載していたよりも短い距離で見つかることある

尤度は物体との距離に応じて減少していくことから、指数分布で表される。

この指数分布はモデル固有のパラメータを使って表せる。

指数分布は自らの位置から本来の対象の位置までの尤度を表すため、累積確率は

- 計測失敗

計測可能レンジの超過

つまり計測値は最大値を示す

- ランダム計測

ごくたまに起きる説明の使いない計測結果

それぞれのエラーの密度関数は、それぞれ重みを掛けて合体することで、本モデルの確率密度関数を表現できる

Limitation of the Beam Model

Beamモデルには2つの主な欠点がある

滑らかさがない

椅子を検知したら椅子の足それぞれマッピングするかもしれない

ロボットの位置が変化したら、beamの座標変換の計算量が大変なことになる

滑らかさの欠如は2つの問題を招く

beliefの近似が正しい状態を見失いやすい

山登り法は局所最大値に陥りやすい

計算量が膨大

4 Liklihood Fields for Range Finders

6.3の制限を解決する尤度フィールドモデルについて述べる。

確率計算などはしないが、実際に使ってみると良い結果が求まる、アドホックなアルゴリズム。

キーとなるアイデアは、の端点をグローバルマップ上に投影すること。

これにより、グローバルマップとロボットのローカルマップの位置関係がわかる。

投影される端点の座標は、

として表される。

このとき、はロボットの座標、

はセンサ検出データの端点

をそれぞれ示す。

Beam Modelと同様に、こちらは3種類のノイズを定義

- 計測ノイズ

計測過程で起こる、ガウス分布でモデル化されるノイズ

- 計測失敗

センサの最大計測可能距離の時を指す。その時、値が正しいかは不明。

- 説明の付かない計測結果

ランダムに発生するノイズ

5 Correlation-Based Measurement Models

文献でよく見かけるmap matchingを使うモデル。

map matchingは、連続するスキャンデータをローカルマップへ落とし込む

つまりmap matchingは、グローバルマップを、ローカルマップを

とした時、尤度

が高い場所を探すことを指す

尤度は、

で表され、グローバルマップとローカルマップの相関係数と平均地図

はそれぞれ、

尤度フィールドに対するmap matchingの利点は、相関係数に応じてフリースペースを決めること。これにより、センサの計測範囲外のデータも考慮してマップを作ることができる

一方map matchingの欠点は、物理的に明確な説明ができないこと

Feature-Based Measurement Model

今まではセンサの生値をベースとした話

これは一歩進んだ、センサデータから求めた特徴量をベースとした話

Featureベースの利点は、特徴量を低次元化することで計算量の削減が可能な点

ロボットの世界では、環境中の特徴量はランドマークと呼ぶことが一般的

特徴量を求める時に一般的なのは、センサがセンサを基準としたランドマークとの距離と方角を計測できるとする仮定

加えて、特徴量抽出器はサイン(本書では数値で表されるとする)を出力する可能性がある

特徴量ベクトルは、距離

と方角

、サイン

それぞれを使って

確率ロボティクスのアルゴリズムでは下記の条件付き確率を仮定する

特徴量ベース地図に向けたセンサモデルの改定

特徴量の地図上での位置をとし、ロボットの座標を

とすると、特徴量の位置は

ここでは、平均0で、分散がそれぞれ

のガウシアン誤差変数

距離・角度センサの主要な問題点は、データの関連付けである。

これを解決するためにと

の間の一致変数

を導入する

の時、

番目の特徴量は

番目のランドマークと一致する

はランドマークの総量

Sampling Poses

今までは特徴量の確からしさについて議論してきた

一方で、特徴量と地図情報からロボットの座標を推定したい時もある

そのためには、事前確率が必要である。

あり得ないが事前確率を均一分布とするとロボットの座標の尤度は

Probabilistic Robotics - Chap.7 Mobile Robot Localization: Markov and Gaussian

7

移動ロボットのローカライゼーションとは、環境地図中でロボットの座標を決める問題である

一方で、座標変換の問題とも捉えることができる

ローカライゼーションとは、地図座標系とロボットのローカル座標系のマッチングをとるプロセスである

ただし残念なことに、ロボットの座標を直接センシングする方法はない。

ノイズの無いセンサなどない。

センサ1つでは座標を求めるには情報が足りない

7.1

ローカライゼーションの問題点を分類してみる

- ローカル VS グローバル

ローカライゼーション問題は起動時もしくは実行中に利用できる知識で特徴づけられる

難しさに応じて3つに分類する

- 位置追跡

この時ロボットの初期座標が既知だとする

計測した位置の含まれる誤差は小さいと仮定

位置追跡は、ロボットの真の座標周辺で起こるローカルな問題

- グローバルローカライゼーション

ロボットの初期座標は不明

- 誘拐ロボット問題(kidnapped robot problem)

グローバルローカライゼーションの一種だが、一層難しい問題

動作中にロボットがどこかに連れ去られたり、テレポートした時の位置特定の問題

- 静的 vs 動的

環境が静的か動的かということ

静的な環境とは、変数がロボットの座標のみ

動的な環境とは、環境中にロボット以外にも、位置や設定が可変なオブジェクトがいる。人や日光など。

動的な環境に対応するには2つの方法がある

- 動的な物体は状態ベクトルに含める

マルコフ仮定で正当化できるが、計算量が増える等の副作用がある

- ある状態下ではモデル化されていない動作を排除する

- パッシブ vs アクティブアプローチ

ローカライゼーションアルゴリズムがロボットの動作を制御できるかどうか

- パッシブローカライゼーション

ロボットの動作のみ観測する

ロボットはローカライゼーションとは別の方法で制御される

例えばランダムに動いたり、日常業務をこなす

- アクティブローカライゼーション

ローカライゼーションアルゴリズムが観測だけでなく、ロボットの制御もする

制御はローカライズの誤差や危険地帯にローカライズの精度が悪いロボットを動かすためのコストを最小化する

アクティブローカライゼーションの重要な制約事項は、アクティブローカライゼーションがロボット全身を制御することが必要な点である。

実際の面では、ローカライゼーション以外のタスクも実行している時にローカライゼーションが出来ることが必要。

- ロボット単体 vs ロボット複数台

ロボットの数で分類

- 単体ロボットのローカライゼーション

ロボット間の通信問題がなく、また全データを単体のロボットへ使えるという便利さ

- 複数台ロボットのローカライゼーション

結局は単体ロボットそれぞれのローカライゼーション問題

7.2 マルコフローカライゼーション

確率的ローカライゼーションのアルゴリズムは、ベイズフィルタの派生

その単純な利用例としてマルコフローカライゼーションがある。

マルコフローカライゼーションのアルゴリズムは下記の通り

マルコフローカライゼーションが対応するのは、静的環境下での

- 位置追跡問題

- グローバルローカライゼーション問題

- 誘拐ロボット問題

初期信念は、ロボットの初期姿勢を反映したもので、ローカライゼーション問題毎に別の値をセットする。

- 位置追跡問題

初期姿勢が既知であれば、は質点分布として初期化される

初期姿勢をとすると、

信念は大抵

を中心とした、分散の小さなガウス分布で初期化する

・グローバルローカライゼーション

初期座標が未知の場合、は、環境地図を対象とした一様分布で初期化する

ここでは、地図内の全姿勢空間の体積(ルベーグ測度*1)である。

7.3 EKF(Extended Kalman Filter)ローカライゼーション

EKFローカライゼーションはマルコフローカライゼーションの特殊ケース

本節で紹介するEKFローカライゼーションは、特徴量の集合でマップが表されるものと仮定

特徴量のIDは、一致変数で表現する

一致変数の値は既知とする

7.4.1

EKFでの単峰な信念を順応させるために、2つのことを仮定する

- 求めた特徴量がどのランドマークと一致するかは既知

- ロボットの初期姿勢は比較的よくわかる(直訳だとこうなんだが日本語としては変だよねぇ。。)

更新後の信念の分散は、更新前の信念や観測密度(p(z|x)だから、観測モデルとしても良い気が。。)よりも小さくなる

→ 独立する推定値を纏めることで、不確かさを小さくすることができるため

7.4.2

本小節では、EFKローカライゼーションの具体例について述べる

特徴量ベースの地図で、速度ベースの運動モデルを使用する

下記はランドマークと特徴量の一致が既知で、回転運動を含む場合(直進のみ、の場合は除く)とする

7.5 Estimating Correspondences

7.5.1 EKF Localization with Unknown Correspondences

今までのEKFローカライゼーションは、ランドマークの一致が不確実性無しに決められる時のみ使えた。でもそんなの極めてまれ。

ローカライゼーションの過程でランドマークの一致を計算する方法としては、maximum likelihood correspondenceがある

ただ不安定さがあるため、2つのテクニックを使う

- 互いを混乱させるような十分にユニークで十分に離れているランドマークを選択することは考えにくい

- ロボットの姿勢の不確かさが小さいことを確認

今までのEKFローカライゼーションと今回のものの主な違いは、measurement updateである。

7.11 Exercise

自分なりの回答を記載してみます。もしもご覧になって、「正解!」「間違っている。。」などのコメントもらえますと幸いです。

1.

(a)1つのランドマークの位置しか同定できていないと、ロボットはランドマークから距離Dだけ離れた円周上に存在することはわかるが、円周上のどこにいるかは特定できない。そのため、確度の低い事後分布が求まる。もしも2つ以上のランドマークの位置を同定すると、2つの円の交点上に存在することになり、位置を高精度に特定できる。そのため、確度の高い事後分布が求まる。

Probabilistic Robotics - Chap.8 Mobile Robot Localization: Grid And Monte Carlo

8.1 Introduction

8章では下記2つのローカライゼーションアルゴリズムについて述べる。

- グリッドローカライゼーション

beliefの計算にヒストグラムフィルタを使う。グリッドローカライゼーションは、グリッドを細かくすると、計算負荷が高くなり処理が遅くなるという問題がある。

- モンテカルロローカライゼーション(MCL:Monte Carlo Localization)

パーティクルフィルタを使ってローカライゼーションを行う、有名なアルゴリズム。欠点は色々とあるものの、誘拐ロボット問題や動的環境下への対応が可能。

これら2つのアルゴリズムは、下記の共通する特徴がある。

- センサ生値を処理するため、特徴量の抽出といった加工処理が不要

- ノンパラメトリック

- グローバルローカライゼーションのための手法であり、誘拐ロボット問題に対応可能

以降では、上記2つのアルゴリズムの詳細を述べる。

8.2 Grid Localization

8.2.1 Basic Algorithm

グリッドローカライゼーションは、ヒストグラムフィルタを利用してグリッドマップ上でのロボットの事後beliefを近似する。つまり事後beliefは、下記の様に各グリッドでの存在確率

の集合

として表せる。また各グリッドの集合であるグリッドマップ

は、

とできる。

グリッドローカライゼーションの擬似コードを下記に示す。グリッドローカライゼーションは、入力として各グリッドでの存在確率と最新の観測結果、制御量、マップ情報を必要とする。そして処理結果として、最新の事後beliefを出力する。疑似コード中の

と

は、Chapter5、6で紹介したどの方法を適用してもよい。

8.2.2 Grid Resolution

グリッドローカライゼーションにおける重要な変数は、グリッドの解像度である。グリッドの決め方には、トポロジカルな方法とメトリックな方法がある。トポロジカルな方法では、環境を特徴的な領域に分割する。ここで言う特徴的な領域とは、ドアや窓といったランドマークが存在する領域を指す。メトリックな方法では、環境の特性を考慮せずに均一なグリッドに分割する。分割数は、特徴的な領域は少ない場合が多いので、メトリックな方法の方が多い。

分割数を多くすると計算負荷が高まるため、解像度は粗くなりがちである。粗さへの対応は、センサモデルと運動モデルの工夫が必要である。例えばメトリックな方法でグリッドを切った場合、グリッドがで、ロボットの速度が

とすると、運動モデルが頻繁に更新してもグリッドの遷移を検出できない。そのため、運動モデルの更新頻度を下げるといった対応が必要である。

8.2.3 Comuputational Consideration

ローカライゼーション時の計算負荷を下げる方法は、沢山検討されている。

- Model pre-caching

予め特定の計測結果を保存しておき、現在の値とその値を比較することで、瞬時に状態を特定可能にする。

- Sensor Subsampling

センサデータを全て処理するのではなく、重要な一部のデータのみを処理する。

- Delayed Motion Update

制御や観測を行うよりも低い頻度でbeliefの更新を行う。

- Selective Updating

8.3 Monte Carlo Localization(MCL)

8.3.2 The MCL Algorithm

ベーシックなMCLアルゴリズムでは、beliefはパーティクルのセットで表現される。beliefの更新方法は下記の擬似コードの通り。

初期beliefは、事前分布を元にランダムに生成した

個のパーティクルとして得る。この時各パーティクルにはimportance factor \

を割り当てる。なお上記擬似コード中の

と

は、グリッドローカライゼーションと同様に、5章、6章で紹介された方法を摘要できる。

8.3.4 Properties of MCL

MCLは殆ど全ての実用上重要な分布を近似できる。一般的なパーティクル数をセットするための戦略は、

と

が更新されるまでリサンプリングしないことである。またMCLの利点として、ノンパラメトリックな近似ができる点がある。

8.3.5 Random Particle MCL: Recovery form Failures

今までに述べたMCLのアルゴリズムでは、グローバルローカライゼーションは可能だが失敗時に復帰できない、誘拐ロボット問題には対処できない、といった問題がある。それは、パーティクルが一度現在の姿勢と異なる場所に集まると、正しい姿勢へ回復できないためである。

これら問題へのシンプルな対応策として、ランダムパーティクルの注入する方法がある。これにより、運動モデルの中にランダムな部分空間が出来る。ではどうやってランダムにパーティクルを注入するべきか。ある種の推論を使って行うのがよい。

1つの方法として、観測モデルを監視し、モデルと平均確率を関連付ける方法がある。(ToDo:よくわからん)平均値は、観測モデルを近似できる。通常数ステップにわたった平均を求めるのがよい。

観測確率が低い理由は、ローカライゼーションの失敗以外にも、センサノイズが異常に高い、パーティクルが空間上に分散しすぎている(集まっていない)、などがある。

パーティクスル数を決める時、数ステップの観測尤度の平均を維持し、より多くのステップの平均に関連付けるとよい。

どの分布を使ってサンプリングするかについての2つ目の問題は、2つの方法で言える。姿勢空間全体を対象とした一様分布を元にパーティクスルをばらまき、現在の観測値を使ってそれらを重み付けする。

例えばランドマーク検出モデルなどのセンサモデルでは、観測モデルの分布に沿ってパーティクルをばらまくことができる。この場合は尤度の沿ってパーティクルをばらまく。

下記にランダムランプルのばらまきを考慮したMCLのアルゴリズムを述べる。

このアルゴリズムは、短期・長期それぞれの平均尤度をトラッキングする点で適応的である。短期・長期の平均尤度は10、11行目で求めている。なお上記

、

は、短期・長期の平均を求める指数フィルタの減衰率であり、

を満たすものとする。

このアルゴリズムの肝であるランダムサンプルの追加は、13行目で行っている。13行目に示すように、短期の平均が長期の平均を下回る、つまり[tex:{1.0 - w_{fast}/w_{slow} \rt 0}}の時、ランダムサンプルが追加される。これにより、観測尤度が急に減少すると、その文ランダムサンプルの沢山追加される。

8.3.6 Modifying the Proposal Distribution

MCLの提案分布は、MCLを非効率なものにする原因の1つである。もしも提案分布と目標分布の差が大きくなれば、精度向上のためにサンプル数を増やす必要がある。提案分布が非効率なことで、ノイズのないセンサの観測結果からロボットの姿勢が寸分の狂いもなくわかるとすると、MCLが失敗することになる。そのためMCLを使う場合、精度の良いセンサよりも悪いセンサを使うことが望ましい。別の方法として、観測モデルに人工的なノイズを乗せるようにてもよい。

その他の方法として、サンプリングプロセスを改良も考えられる。例えば動作モデルと観測モデルの役割を入れ替える、混合モデルが考えられる。混合モデルでは、観測モデルがパーティクルの生成、重みの更新を行う。混合モデルは、誤差の低減や誘拐ロボット問題へ対応が可能だが、実装には困難が伴うという問題もある。

8.4 Localization in Dynamic Environment

これまでに述べたローカライゼーション手法の重要な制約は、静的な環境を仮定している。そのため、人などの動体を考慮していない。ただし確率的なアプローチでは、ノイズを考慮しているため、結果としてある程度動体を考慮している。一方で、センサノイズは各ステップ毎に独立していると仮定しているが、実際には数ステップにまたがって影響している。

こうした動的な環境に対応する方法として、状態拡張(state augmentation)と外れ値の除外(outlier rejection)という2つの基本技術がある。前者を適用することで、ロボットの姿勢だけでなく人の特性(位置、速度など)を推定できるフィルタを定義できる。ただし計算が複雑になると言った問題がある。後者は、センサデータがなぜこの値になったかの原因追求と、モデル化していない動体の影響を受けたと思われる高尤度なデータを排除する。

この方法は、本質的にはEMアルゴリズムと同じことを行う。ここで、観測モデルとして6.3節の式(6.12)を考え、新たに変数を導入する。

ここでは、

を示すものとする。

アルゴリズムは上記の通り。入力はbeliefの代替であるパーティクルの集合

とレンジファインダの観測データ

、地図

である。出力は入力した

の"reject"か"accept"のどちらか一方である。

reject/acceptの判断は、観測結果が想定よりも驚くほど短いかどうかで行う。地図上に人などの動体が存在する場合、壁よりも近い場所に何かを検出することになる。そのため、観測結果が想定よりも顕著に短い場合はrejectする。

外れ値のrejectは、一般的には良い考え方である。測距計以外のセンサでも同様の考え方を使って観測モデルを更新できる。

Probabilistic Robotics - Chap.5 Robot Motion

5.1 Introduction

モーションモデルはベイズフィルタの予測ステップにおいて肝となる状態遷移確率を構成する。本章では、ロボットの運動はある平面上での移動のみを取り上げる。

5.2 Preliminaries

5.2.1 Kinematic Configuration

ロボットの姿勢は下記の式で表せるものとする。

ロボットの向きはよく、や

と呼ばれる。また姿勢から向きを取ったものは

と呼ぶ。

5.2.2 Probabilistic Kinematics

状態遷移確率はとして表される。

はそれぞれ、時刻

でのロボット状態を、

は時刻

でのモーションコマンドを、それぞれ表すものとする。モーションモデルにおいて、

はオドメトリを指す場合もある。

本章では、下記2種類の確率的モーションモデルを取り上げる。

- 速度モーションモデル

なモデル。ただし速度を指令値通り制御することは、ノイズ等の都合上難しいことため、精度は良くないことが多い。

- オドメトリモーションモデル

なモデル。速度モデルよりも精度が高いことが多い。

ただしオドメトリは動いた結果わかる情報である。そのため、動作の予測には使えない。そのため、速度モデルはモーションプランニングに、オドメトリモデルは状態推定に、それぞれ使うことが一般的である。以降ではそれぞれについて詳細を述べる。

5.3 Velocity Motion Model

本モデルは、ロボットの速度は並行運動

と回転運動

の2種類で構成されると過程する。なお

と

は、それぞれ1次元のスカラ値である。

5.3.1 Closed Form Calculation

速度モデルは、下記のアルゴリズムで表現される。

ここでから

は、ロボット固有の誤差パラメータでる。また

は、モーションエラーをモデル化した関数を表す。この固有パラメータの決定方法について、特に本書には記載がないです。恐らく指令値と実測値の組み合わせを記録していき、その結果が良い感じに

の結果とフィットするようにパラメータチューンが必要と思われます。

5.3.2 Sampling Algorithm

5.3.1では計算で求めていましたが、本節ではパーティクルフィルタの様にサンプリングを介して解析に状態遷移確率を求める手法を紹介します。サンプル点から求める際の下記の手法を使う。

2~4行目は、速度パラメータにノイズを加えます。その結果を使い、5~7行目で姿勢を計算しています。サンプリング手法を使う場合、運動方程式等の物理モデルを考慮せず、サンプル点の位置からのみ姿勢が求まるという利点がある。そのため実装の観点からすると、サンプリング手法を利用ことが楽である。

5.4 Odometry Motion Model

オドメトリは、ドリフトやスリップによってエラーは生じるものの、速度に比べて計測誤差が小さい。また実際に動いた後でないと計測できないため、モーションプランニングには使えない。

5.4.1 Closed Form Calculation

オドメトリをベースとしたモーションモデルは、今日の確率ロボティクスベースのシステムで中心的な役割を果たしている。

オドメトリは、ロボット内部の情報量である。そのため、実世界とリンクするためには座標変換が必要である。ただしドリフトやスリップが生じるため、変換行列は一定ではない。なおこの変換行列を求めることは、自己位置推定を行うことと等価である。

オドメトリモデルは相対動作情報を使用する。相対動作情報とは、時刻から

の間で、どの程度動いたかを表す情報である。ロボットの時刻

と

の時の姿勢のペアを

とすると、

となる。

この動作情報から相対動作情報を取り出すと、回転・直進・回転の3ステップに分割できる。つまり

と表せる。この情報が分かれば、ある時刻から

の間の移動を再現できる。

確率的モーションモデルでは、上記3パラメータはノイズが加わっているものと仮定する。

以上を踏まえた、オドメトリモデルでの状態遷移確率を求めるアルゴリズムは下記の通りである。

なおは、平均

で分散

の誤差分布における

の発生確率を返す関数とする。また、

から

は、ロボットの動作を特定するロボット固有のパラメータである。

上記アルゴリズムにおいて、各行が行っている内容は下記の通り

- 2~4行目:オドメトリ情報から相対動作情報

を抽出。

- 5~7行目:入力した姿勢

と

から理想とする相対動作情報を算出。

- 8~10行目:相対動作情報の各要素に対するエラーを確率的に計算

- 11行目:相対動作情報の各要素に対するエラー発生確率をかけ合わせ、目的姿勢である

からのずれを返す。

5.5 Motion And Maps

今まで扱っていた状態遷移確率では、周囲環境を考慮していなかった。そこで状態遷移確率のパラメータとして、新たに地図を導入する。地図を知ることで、壁などの到達不可能な場所にいるのか、そうでない到達可能な場所にいるのかが判別できる。これにより、ロボットの姿勢をより精度良く求める事が可能となる。

地図の導入により、状態遷移確率はとなる。地図を知ることによって、今まで議論してきた状態遷移確率では「遷移可能」としてきた場所に遷移出来なくなるので、

となる。よって新規なモデルとなることから、マップベースモーションモデルと呼ぶことにする。

マープベースモデルを閉形式で計算することは難しい。一方で、都合の良いことに計算効率のよい近似方法がある。近似式は下記の通り。

ここでは正規化係数である。通常

は一様分布で表される。なお周囲環境は動的に変化しないことから、

は定数として考える。もしも

の時は、ロボットは地図上に存在する障害物上に存在することを意味する。

なお上記近似には問題がある。モデルでは地図を考慮しているため、ロボットが存在できる姿勢は全て遷移対象となる。しかし、例えば壁の向こう側に一瞬で行くのは難しいが、そうした物理的に遷移が可能かは考慮していない。そのため、遷移先の姿勢への移動コスト加味するなどの工夫が必要である。